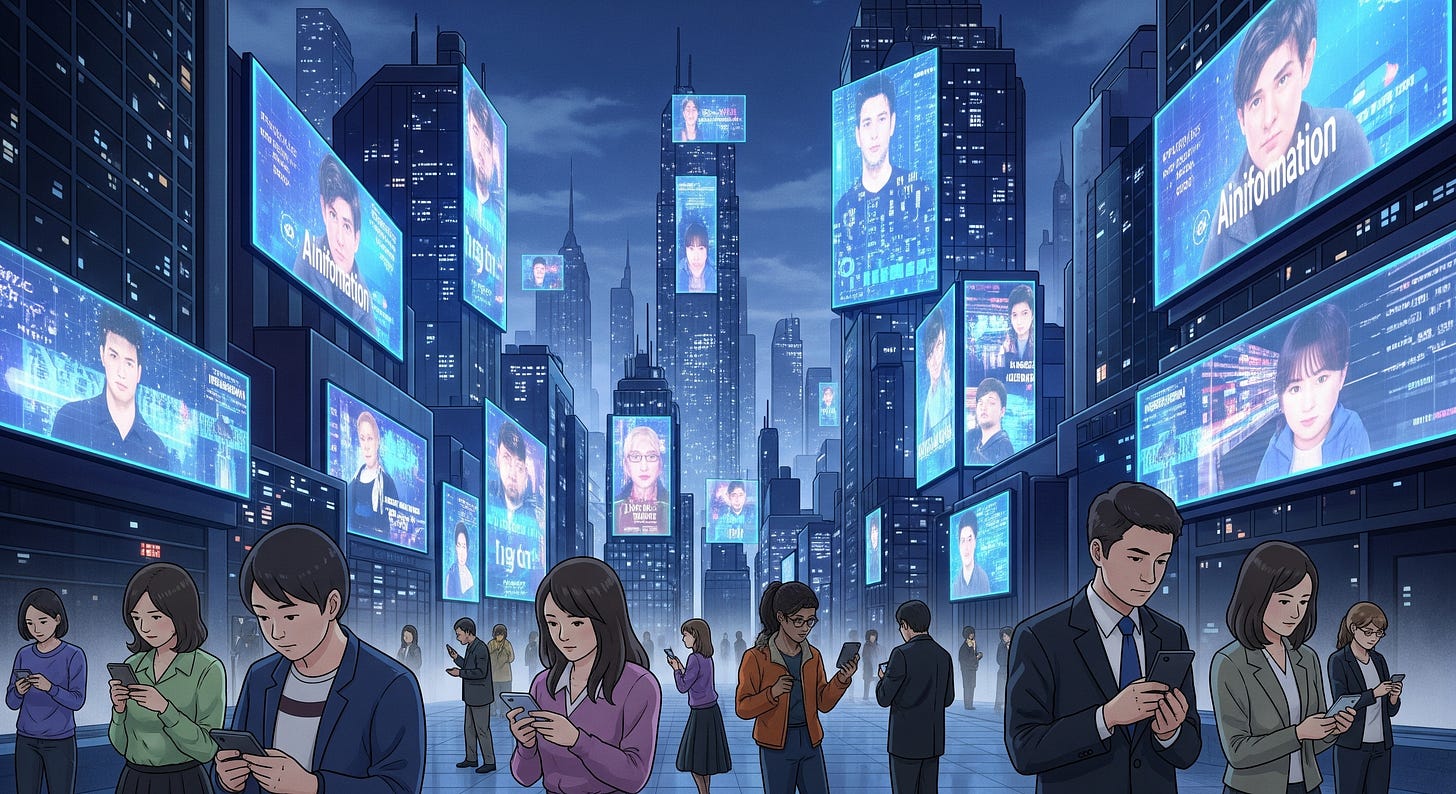

Az AI-vezérelt befolyásolási műveletek

Elemzés és válaszkeresés

A mesterséges intelligencia alapjaiban alakította át a befolyásolási műveletek tájképét, gyorsabbá, olcsóbbá és áthatóbbá téve azokat. A fenyegetés nem csupán specifikus hamis narratívákról szól, hanem a bizalom rendszerszintű eróziójáról, az információs környezet szennyezéséről és a demokratikus integritás kihívásáról. A 2024-ben megfigyelt választási …